Notice

Recent Posts

Recent Comments

Link

Jeunwork space

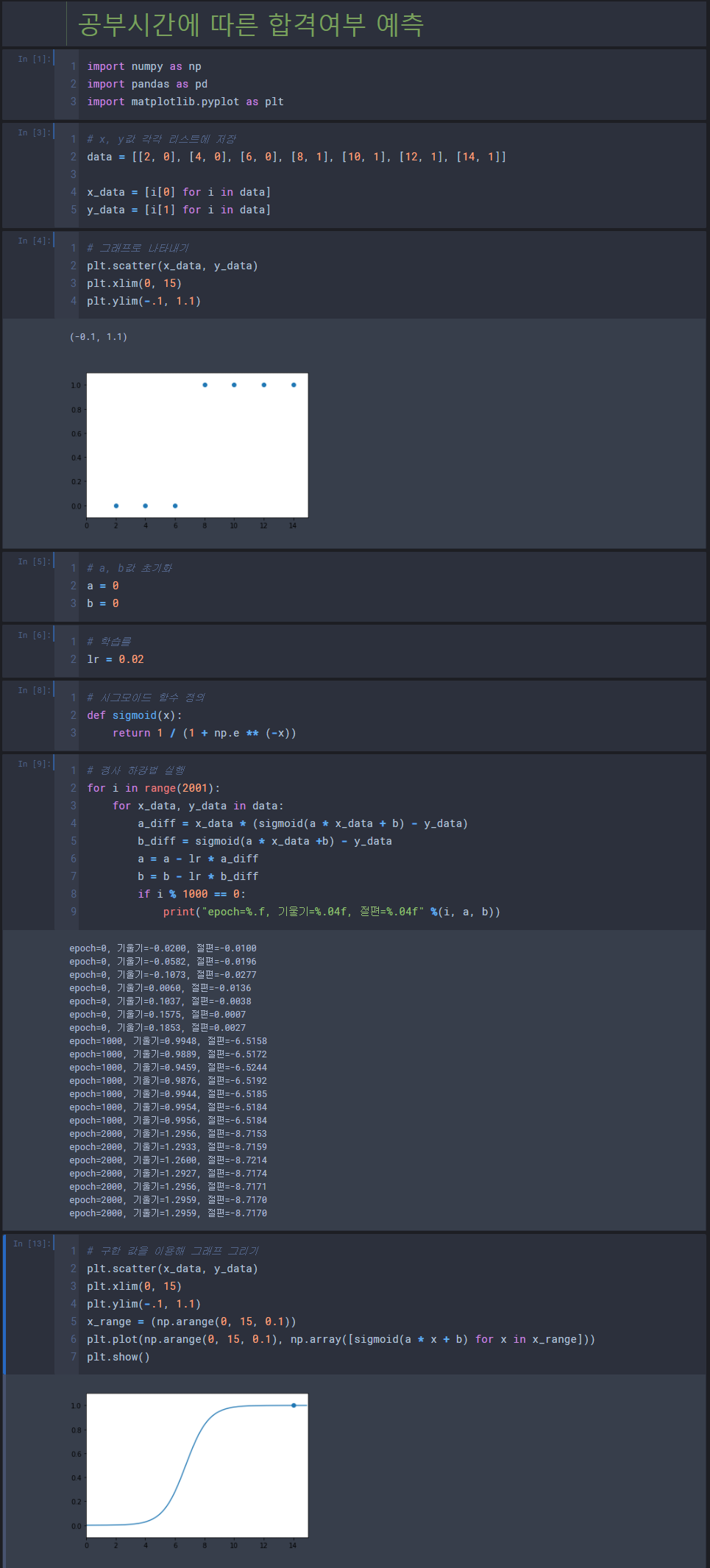

모두의 딥러닝 5장 - 로지스틱 회귀 본문

로지스틱 회귀

- 직선이 아닌, 참(1)과 거짓(0) 사이를 구분하는 S자 형태의 선을 그어주는 작업 → 시그모이드 함수 이용

- 시그모이드 함수 공식

- 특징

y값이 0 과 1사이

- 실제 값이 1일 때 예측 값이 0 에 가까워지면 오차가 커지고, 반대로 실제 값이 0일 때 예측 값이 1에 가까워지면 오차가 커진다. 이를 공식으로 만들면 → 로그 함수

- 규칙

a는 그래프의 경사도를 결정한다. → a의 값이 커지면 경사가 커지고, a값이 작아지면 경사가 작아진다.

b는 그래프의 좌우 이동을 의미한다.

a값이 작아지면 오차는 무한대로 커지나, a값이 커진다고 해서 오차가 무한대로 커지지는 않는다.

'Deep Learning' 카테고리의 다른 글

| 모두의 딥러닝 8장 - 오차 역전파(back propagation) (0) | 2021.06.07 |

|---|---|

| 모두의 딥러닝 6장 - 퍼셉트론 (perceptron), 7장 - 다중 퍼셉트론 (0) | 2021.06.07 |

| 모두의 딥러닝 4장 - 다중 선형 회귀 (0) | 2021.06.07 |

| 모두의 딥러닝 4장 - 경사 하강법 (0) | 2021.06.07 |

| 모두의 딥러닝 3장 - 최소 제곱법, 평균 제곱 오차 (0) | 2021.06.07 |

Comments