Notice

Recent Posts

Recent Comments

Link

Jeunwork space

모두의 딥러닝 6장 - 퍼셉트론 (perceptron), 7장 - 다중 퍼셉트론 본문

퍼셉트론

- 신경망을 이루는 가장 중요한 기본 단위

- 입력 값과 활성화 함수를 사용해 출력 값을 다음으로 넘기는 가장 작은 신경망 단위

- 로지스틱 회귀가 퍼셉트론의 개념

y = wx + b (w는 가중치, b는 바이어스)

- 가중합(weight sum)

입력값 x와 가중치w의 곱을 모두 더한 다음 거기에 바이어스 b를 더한 값

가중합의 결과를 놓고 1 또는 0을 출력해서 이를 판단하는 활성화 함수(activation function)로 보낸다.

대표적인 활성화 함수 = 시그모이드 함수

- 퍼셉트론의 한계

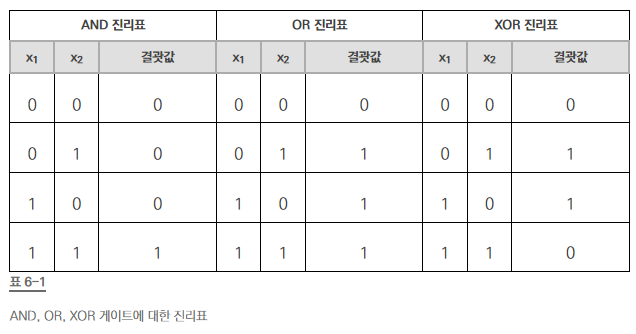

XOR 문제(둘 중하나만 1일 때 1이 출력) 해결하지 못한다.

이를 해결하기 위한 방법

↓

다중 퍼셉트론

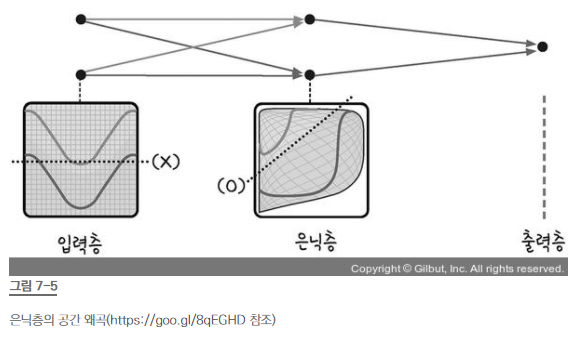

- 숨어있는 층, 즉 은닉층을 만들어 공간을 왜곡하면 두 영역을 가로지르는 직선을 그을 수 있다.

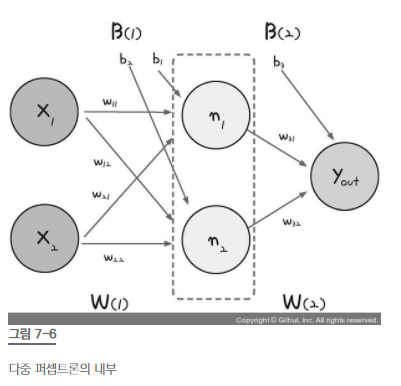

- 가운데 숨어있는 은닉층으로 퍼셉트론이 각각 자신의 가중치와 바이어스 값을 보내고, 이 은닉층에서 모인 값이 한번 더 시그모이드 함수를 이용해 최종 값으로 결과를 보낸다.

- 은닉층에 모이는 중간 정거장 : 노드

- 각 노드의 단일 퍼셉트론의 값

n1 = σ(x1w11 + x2w21 + b1)

n2 = σ(x1w12 + x2w22 + b2)

- 최종 출력값

y = σ(n1w31 + n2w32 + b3)

- 은닉층을 포함해 가중치 6개와 3개의 바이어스가 필요하다.

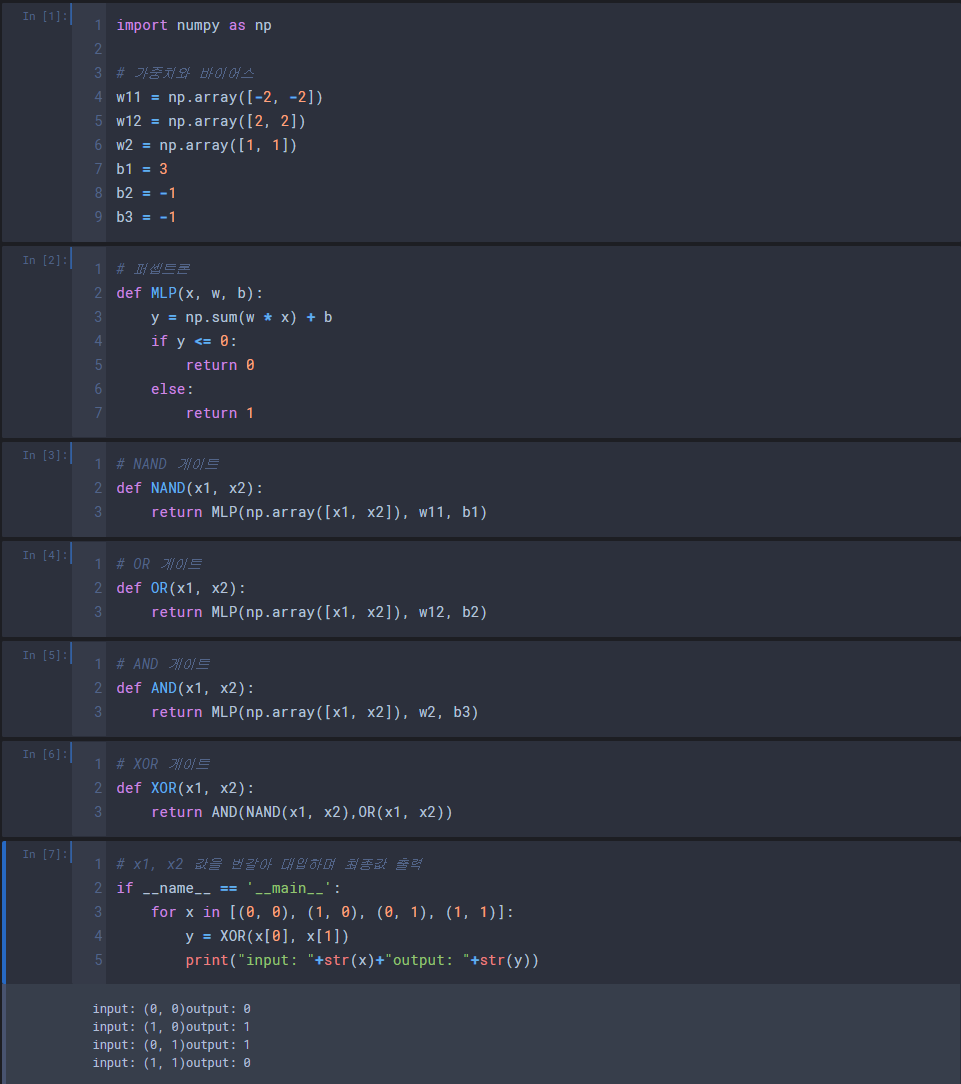

- 다중 퍼셉트론 XOR문제

'Deep Learning' 카테고리의 다른 글

| 모두의 딥러닝 10장 - 모델 설계 (0) | 2021.06.07 |

|---|---|

| 모두의 딥러닝 8장 - 오차 역전파(back propagation) (0) | 2021.06.07 |

| 모두의 딥러닝 5장 - 로지스틱 회귀 (0) | 2021.06.07 |

| 모두의 딥러닝 4장 - 다중 선형 회귀 (0) | 2021.06.07 |

| 모두의 딥러닝 4장 - 경사 하강법 (0) | 2021.06.07 |

Comments